05 Mar Deep Learning: beaucoup d’effets d’annonce pour peu d’innovation…

Articolo tradotto in francese da Eric Pichelingat per www.sautcreatif.com che ringrazio per la considerazione.

Qui il link alla traduzione.

Qui il link per chi volesse leggerlo in italiano.

***

Le deep learning, associé au machine learning et à l’énorme réservoir de Big data a permis de donner naissance à l’Intelligence Artificielle. Un ensemble de technologies très prometteuses si l’on en croit la presse qui ne jure que par elles et leurs applications à tout-va dans nos vies, nos maisons, nos smartphones, nos objets connectés… Mais on ne vous parle que de ce qui marche !

Article en italien de la journaliste Giuditta MOSCA “Deep learning: ancora troppo fumo e poco arrosto, ma si parla solo di quello che funziona”, paru le 27 décembre 2018 sur le site Businessinsider.it et traduit par Eric PICHELINGAT avec l’aimable autorisation de l’auteur.

Trop de battage médiatique autour du deep learning

Commençons donc par expliquer ce qu’est un « hype » et ce qu’est le deep learning. Par« hype » comprenez la rumeur faite sur une personne ou sur un fait, cette voix insistante et puissante qui projette son sujet en tête de l’actualité et des opinions positives. Souvent, cependant, c’est un feu de paille, une mode passagère qui diminue au fur et à mesure que les résultats contredisent les attentes.

Le deep learning – apprentissage en profondeur – crée des modèles d’apprentissage à partir des notions qui lui sont transmises par des algorithmes, qu’il organise de de manière pyramidale, ce qui lui permet d’apprendre des concepts plus complexes à partir des plus simples.

Bien qu’il soit correct de dire que le deep learning a fait des pas de géant, il convient d’avoir un regard critique sur la renommée qui lui est faite à travers le battage médiatique dans la presse généraliste et les stratégies de communication déployées par les chercheurs. Tous ces efforts visent à montrer au public seulement les succès obtenus, se concentrant rarement sur les perspectives et les attentes de croissance.

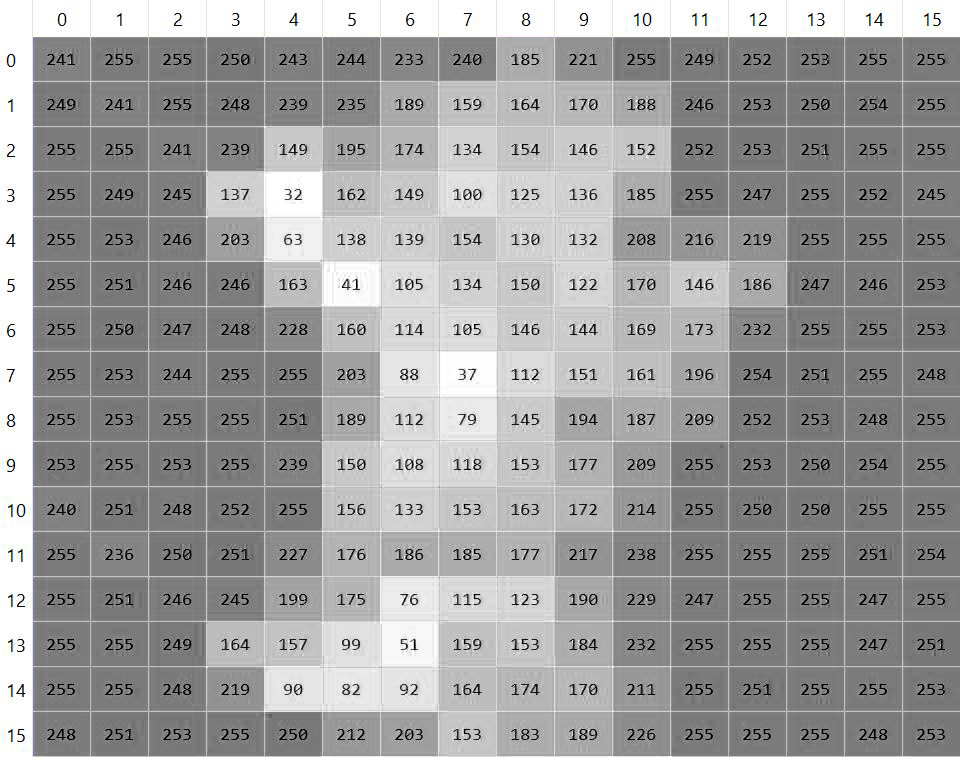

Deux éléments ont contribué à une nette accélération du deep learning : la technologie de plus en plus performante et la facilité avec laquelle on peut trouver des données et des informations (Big data). Classées en entrées et sorties, ces data fournissent ainsi des réponses ciblées au problème posé au deep learning.

Le deep learning est proche de l’âge de la retraite

En 1958, il y a 60 ans, le psychologue Frank Rosenblatt présentait le perceptron, un réseau de neurones contrôlé par un ordinateur de l’époque. Un événement qui exalta les journalistes, certains qu’il suffirait de quelques années pour que les ordinateurs soient capables de parler et d’avoir leur propre conscience. L’objectif de Rosenblatt était d’avoir une machine capable de réduire les erreurs, objectif répété pendant plus d’un quart de siècle avec des fortunes diverses. Le deep learning n’est pas tout jeune et traverse un de ses moments d’or, mais penser qu’il est capable de tout faire est un leurre.

What’s the “problème” ?

Le moment du deep learning associé au machine learning – apprentissage automatique – est propice parce qu’il contribue à cette construction communément appelée l’intelligence artificielle.

Ce sont des milliers de startups qui exploitent les études et les résultats pour s’imposer sur le marché, en ligne avec la prophétie facile de Kevin Kelly, l’écrivain culte aux multiples facettes des sciences digitales. Ce dernier soutenait en 2014 que pour fonder avec succès une entreprise, il suffisait de prendre un objet déjà existant et de le rendre intelligent.

Le fait est que les médias, surtout la presse généraliste, sont trop enclins à montrer ce que le deep learning est capable de faire, sans s’appesantir sur ce qu’il n’est pas encore en mesure de proposer.

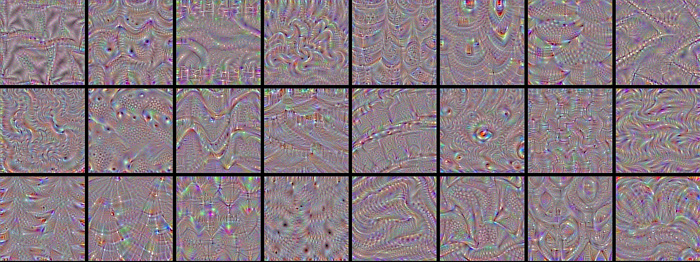

Les réseaux de neurones convolutifs

Ce sont des réseaux artificiels inspirés du cortex visuel animal qui organisent le champ de vision pour reconnaître les images et les vidéos. Une étude, dont les conclusions ont été rendues publiques en février 2018 et menée par les chercheurs Matthew Ricci, Junkyung Kim et Thomas Serre, affirme que :

les limites de ces réseaux sont très strictes. Les algorithmes ne sont pas en mesure d’établir des relations entre les images et, confrontés à des problèmes apparemment insolubles, ils entraînent la rupture des réseaux de convolution sur lesquels ils “tournent”.

Il s’agit d’un problème très complexe dont la représentation peut échapper aux lecteurs moins habitués au sujet. Pour donner un exemple (seulement en partie), nous pouvons dire que les systèmes de reconnaissance d’image que nous utilisons déjà, tels que ceux proposés par Google, peuvent archiver les photos que nous prenons avec nos appareils mobiles en fonction de certains paramètres, tels que les personnes ou lieux que nous immortalisons. Mais c’est tout ce qu’ils sont en mesure de faire. Si nous allons au Parc Olympique Lyonnais pour voir le derby, les photos que nous prendrons seront organisées dans répertoire “Parc Olympique Lyonnais” mais Google ne saura pas dire que sur le terrain il y avait Lyon et Saint-Etienne.

Vision d’ordinateur

Pour faire en sorte que les voitures à conduite autonome remplissent vraiment nos rues, la vision par ordinateur doit être fiable. Dans ce cas, même en simplifiant grossièrement le concept, deux environnements particuliers entrent en jeu, celui de la détection d’objet et celui de leur classification et de leur localisation. Ces deux environnements, bien accouplés,contribuent à créer une cartographie simultanée qui permet aux voitures à conduite autonome de circuler en toute sécurité sur les routes. Pourtant, en 2016, un système de conduite assistée n’a pas reconnu la carrosserie d’un camion, de couleur trop claire pour être clairement mise en évidence et séparée du ciel, provoquant ainsi un accident mortel.

Le chercheur Zeeshan Zia, expert en vision par ordinateur et en machine learning (construction basée sur le travail effectué par le deep learning) maintenant utilisés par Microsoft, est convaincu que les techniques de cartographie en temps réel ne sont efficaces que dans des environnements statiques et beaucoup moins précises en environnements dynamiques. Autrement dit, le système de reconnaissance visuelle des voitures à conduite autonome est parfait seulement si elles ne bougent pas (ou très lentement). Selon Zeeshan, de grands progrès ont été réalisés ces dernières années, favorisant pour le moment le développement de viseurs pour la réalité augmentée et n’apportant que de petites améliorations à l’application robotique.

Réalité ou fiction ?

Il existe aussi des problèmes abstraits, car en réalité,

le deep learning n’existe que dans la mesure où l’homme alimente les réservoirs de données et, par conséquent, il hérite des imperfections de la pensée humaine.

Le deep learning ne s’interroge pas sur la qualité des données qui lui sont données à digérer et fonctionne en traitant des informations qui peuvent être mauvaises dès le début. Le deep learning fait partie intégrante du machine learning et constitue une partie minime de l’intelligence artificielle. Il est donc facile à comprendre qu’une erreur de marquage due au deep learning se répercutera sur toute la chaîne.

Pour le deep learning, la réalité vaut la fiction, il n’est pas capable de les distinguer, car il considère comme valide une donnée qu’il élabore plusieurs fois et moins valide une donnée à laquelle il est confronté rarement. Les statistiques obtenues peuvent donc être inexactes.

Reinforcement learning : apprendre par renforcement

Le terme reinforcement learning -apprentissage par renforcement- fait référence à une technique par laquelle les systèmes apprennent à s’adapter à l’environnement dans lequel ils se trouvent et réagissent aux changements de l’environnement lui-même. Une voie dans laquelle de nombreux chercheurs se lancent car elle s’adapte à beaucoup de domaines, de la conduite autonome au gaming.

Selon Alex Irpan, chercheur de renom de la Google Brain Team qui s’occupe du développement de l’intelligence artificielle, dans 70% des cas, le reinforcement learning ne fonctionne pas.

La route est encore très longue et les progrès sont de plus en plus significatifs. Mais ce futur qui semble imminent est encore vraiment très lointain.